Nie tylko rozpoznawanie stron, ale również nazw przedmiotów, kolorów i kształtów. Roboty stają się coraz bardziej inteligentne, a naukowcy nie odpuszczają. Tym razem za punkt honoru postawili sobie szybką reakcję AI na instrukcje wydawane przez człowieka. Jak im poszło?

Płynność w rozumieniu komunikatów

Do tej pory roboty były szkolone w ten sposób, aby rozumiały podstawowe komunikaty, które wydaje człowiek. Oznacza to, że AI potrafiła podnieść szklankę, postawić ją po prawej lub lewej stronie, ale na tym możliwości się kończyły.

Sytuacja ta nie podobała się naukowcom z Uniwersytetu we Fryburgu w Niemczech. Rozpoczęli oni pracę nad takim rodzajem ulepszenia robota, aby rozumiał nie tylko podstawowe informacje. W tym celu zmienili sposób trenowania AI za pomocą scen halucynacyjnych, czego potwierdzeniem jest artykuł opublikowany na arXiv Międzynarodowej Konferencji Robotyki i Automatyzacji IEEE (ICRA) w Paryżu, w czerwcu tego roku.

źródło: techxplore.com

Jak czytamy w serwisie techxplore.com, Oier Mees, jeden z badaczy twierdzi, że podczas tych badań koncentrują się na tym, aby wzbogacić partie inteligentne, odpowiedzialne za rozróżnianie przedmiotów.

Czy badania przynoszą rezultaty?

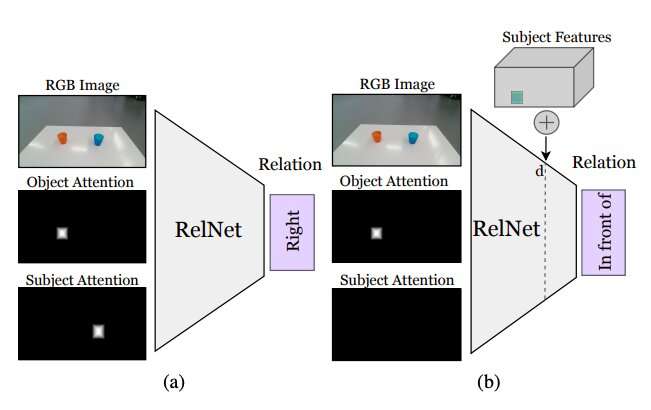

Według Meesa AI potrafi teraz zareagować na komunikat typu: umieść kubek po prawej stronie pudełka, czy nawet umieść żółtą zabawkę w pudełku. W tym celu za pomocą uczenia maszynowego robot musi zrozumieć komunikat, a następnie dokonać analizy swojego aktualnego położenia. Zespół naukowców zajął się również technologią związaną z pikselami, aby AI mogła swobodnie modelować relacją przestrzenną i właśnie to pomaga zrozumieć robotom rzeczywistość.

źródło: techxplore.com

Przed szkoleniem sieci neuronowej, w celu poznania relacji przestrzennych opartych na halucynacyjnych obiektach, kolejnym krokiem było sklasyfikowanie powiązań pomiędzy poszczególnymi obiektami.

W rezultacie, możemy zobaczyć następujące efekty:

Jaki będzie ostateczny rezultat tych badań? Zobaczymy w czerwcu, ale na pewno nasze nadzieje na rozwój AI zwiększyły się znacznie.