Komunikacja na polu człowiek i robot stale się rozwija. Roboty humanoidale naukowcy chcą coraz bardziej uczłowieczać, w związku z czym dbają o ich elastyczność i empatię. Ważnym elementem tej ostatniej cechy, jest wyrażanie emocji. Jednak i nad tym prace już trwają.

iCube – robot, który marszczy brwi

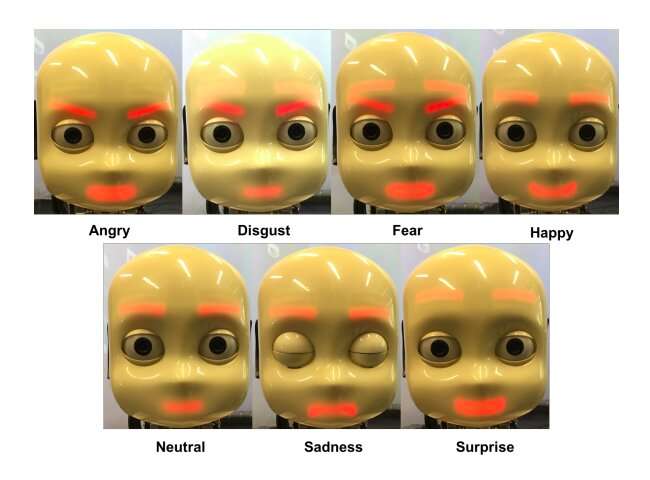

Naukowcy z Uniwersytetu w Hamburgu w Niemczech, za pomocą maszynowego uczenia opracowali metodę, dzięki której roboty będą w stanie wyrazić podstawowe emocje. Jest ich siedem.

źródło: techxplore.com

Technika ta, została przetestowana na humanoidalnym robocie o nazwie iCube i opracowana na znanych już naukowcom ramach zwanych TAMER. Można go użyć do szkolenia wielowarstwowych perceptronów (MLP) oraz klasy sztucznych sieci neuronowych (ANN). Jak czytamy w serwisie techxplore.com, robot ten wykorzystuje neuronowe sploty sieci neuronowej i połączenia samoorganizującej się mapy. Wszystko po to, aby robot sam mógł wyrażać swoje emocje.

Skąd robot zna te emocje?

Połączenia będące splotem sieci neuronowych (CNN), które wykorzystują naukowcy, analizują sposób mimiki widoczny na obrazach gromadzonych w bazach danych, a następnie przypisują mu konkretną emocje. Następnie, analiza ta przesyłana jest samoorganizującej się mapie, ujawniające wzorce zachowań adekwatne do emocji. Kolejnym krokiem jest przesłanie ich wielowarstwowym perceptronom, których zadaniem jest trenowanie emocji i nagrodzenie robota, gdy ten wykona poprawne polecenia. I jak się okazało, metoda ta osiągnęła zadowalające efekty z wykorzystaniem zrobotyzowanej platformy iCub. Czy to oznacza, że za kilka lat uśmiech robota będzie dla nas czymś oczywistym?